| 阿里云服务器ECS使用教程-使用AMD CPU实例部署通义千问Qwen-7B-Chat |

|

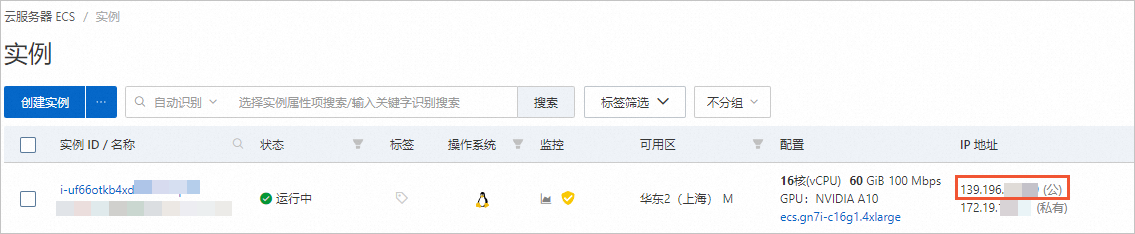

阿里云服务器ECS使用教程-使用AMD CPU实例部署通义千问Qwen-7B-Chat 本文以搭建AI对话机器人为例,介绍如何使用阿里云AMD CPU云服务器(g8a)部署Qwen-7B模型。 背景信息通义千问-7B(Qwen-7B)是阿里云研发的通义千问大模型系列的70亿参数规模模型。Qwen-7B是基于Transformer的大语言模型,在超大规模的预训练数据上进行训练得到。预训练数据类型多样,覆盖广泛,包括大量网络文本、专业书籍、代码等。同时,在Qwen-7B 的基础上,使用对齐机制打造了基于大语言模型的AI助手Qwen-7B-Chat。 创建ECS实例

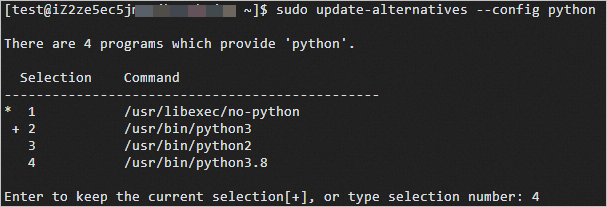

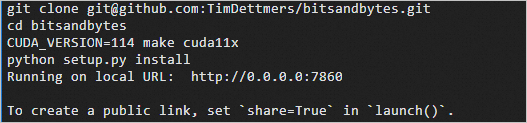

部署Qwen-7B-Chat步骤一:安装配置模型所需软件

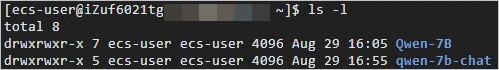

步骤二:下载源码与模型

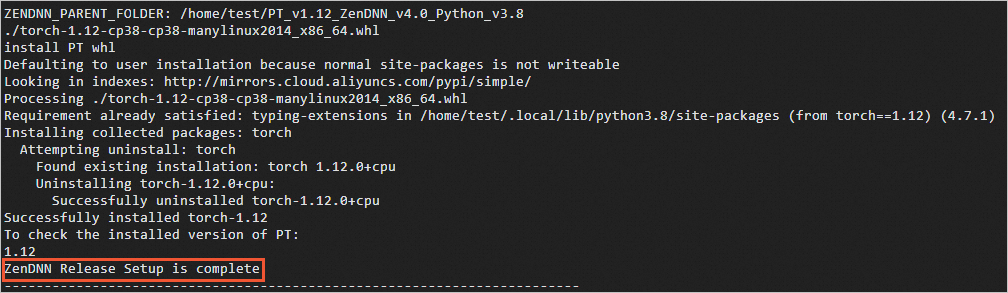

步骤三:部署运行环境

步骤四:进行AI对话

|

206

新用户注册立享888元代金券大礼包!

免费注册

- 100倍故障赔偿

- 3天无理由退款

- 7x24小时服务

- 0元快速备案

- 1V1专席秘书

Copyright © 2023 版权所有:湖南尊托云数科技有限公司  工信部ICP备案号:湘ICP备2022009064号-1

工信部ICP备案号:湘ICP备2022009064号-1  湘公网安备 43019002001723号

湘公网安备 43019002001723号  统一社会信用代码:91430100MA7AWBEL41 本站为小鸟云代理商:

统一社会信用代码:91430100MA7AWBEL41 本站为小鸟云代理商: 《增值电信业务经营许可证》B1-20160477

《增值电信业务经营许可证》B1-20160477