👉点击这里申请火山引擎VIP帐号,立即体验火山引擎产品>>>

背景信息

机型限制

单机训练:支持GPU计算型和高性能计算GPU型实例。

多机训练:仅支持高性能计算GPU型实例,且不包括hpcg1ve和hpcpni3h。其中,hpcpni3h实例正在邀测中,如需使用,请联系客户经理申请。

准备环境

您已拥有一台或多台GPU实例,本文分别命名为node1、node2。每台实例的基本配置如下:

云盘空闲容量在90GiB以上。

已绑定公网IP,使其具备访问公网的能力。

本文GPU实例的镜像以Ubuntu 20.04为例,您也可以任选其它镜像。

参考登录Linux实例登录各节点,并完成下述操作。

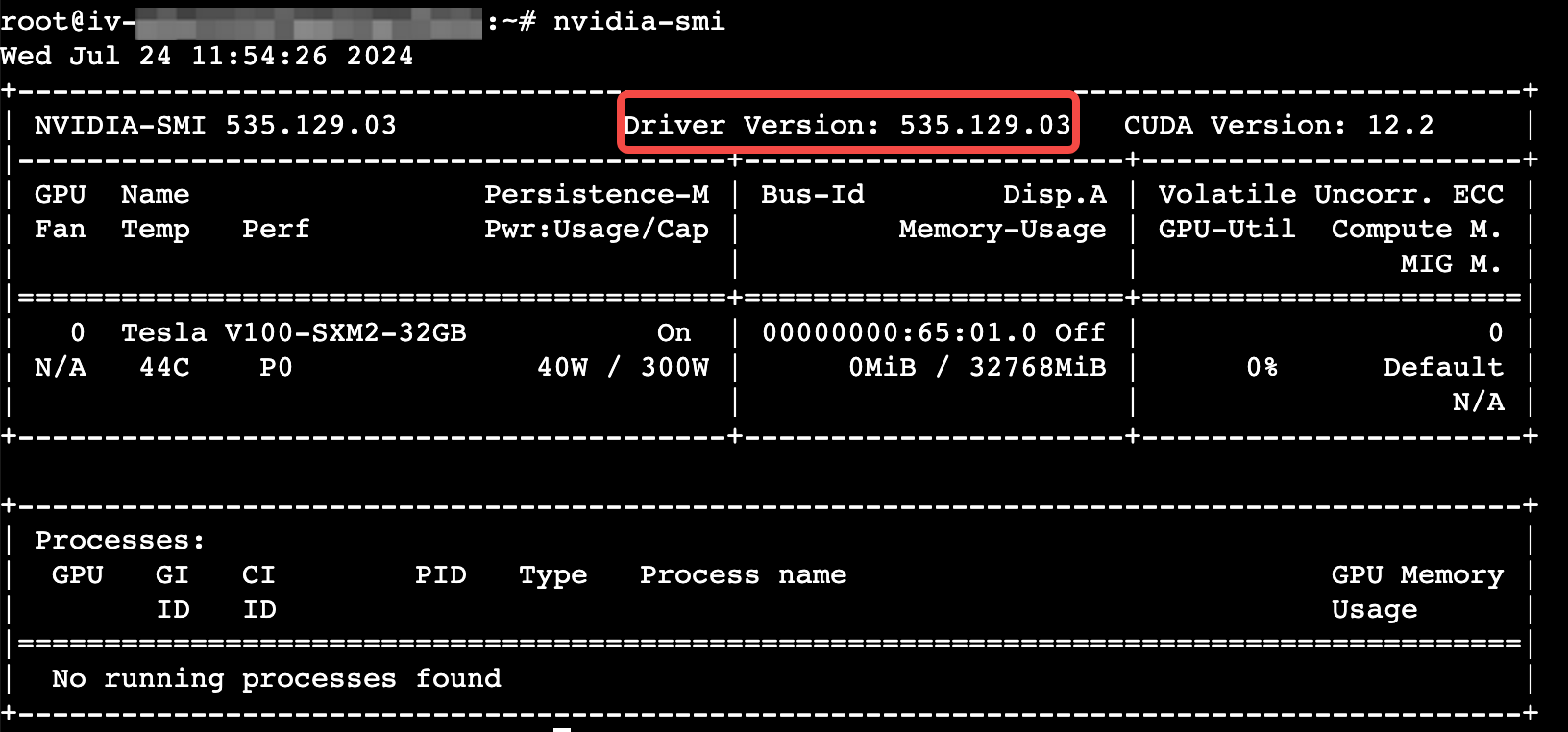

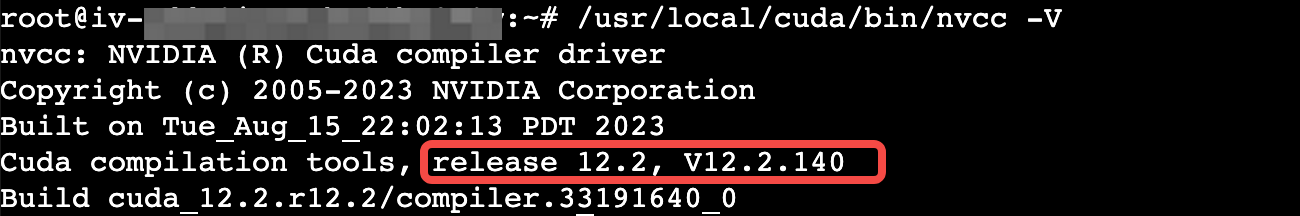

已安装GPU驱动和CUDA工具包。

nvidia-smi/usr/local/cuda/bin/nvcc -V

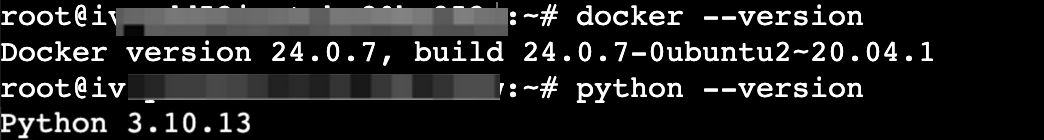

已安装Python和Docker。

python --versiondocker --version

操作步骤

参考文件传输概述,将以下mlp_easy_gpt.py文件上传至云服务器实例。

在实例内部执行以下命令,运行mlp_easy_gpt.py脚本。

请将-i后的IP替换为每台实例主网卡的私网IP地址,不同IP之间用“,”分隔,顺序可以互换。如何查看私网IP地址,请参考查看实例信息。

如果是单机环境,请执行:

python3 mlp_easy_gpt.py -i <实例的私网IP地址>

如果是多机环境,请执行:

python3 mlp_easy_gpt.py -i <node1的私网IP地址,node2的私网IP地址>

结果判定

类型 | node1(主节点) | node2 |

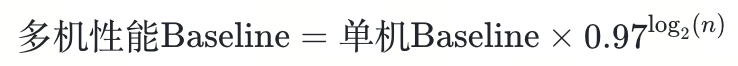

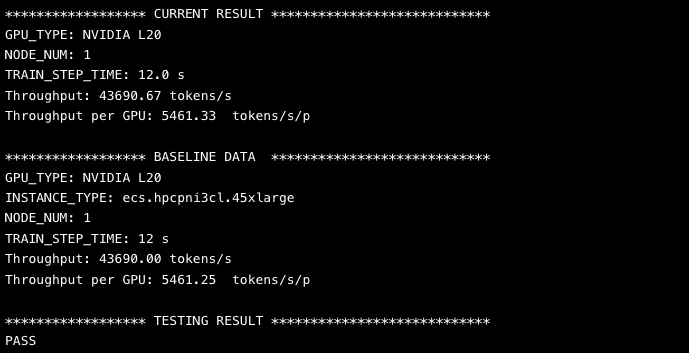

查看性能 | 说明 主节点输出性能数据,多节点性能数据以单节点线性扩展,计算公式如下:

其中,n为机器数量,实测性能大于Baseline,则代表机器性能符合预期。

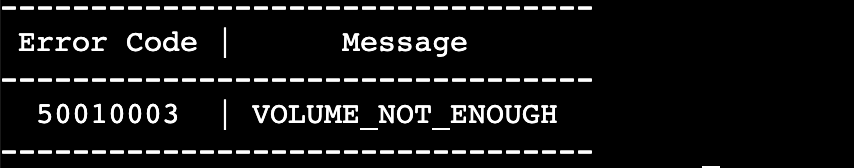

部分错误码说明如下:

| 无操作 |

收集日志 | 主节点收集distributed_gpt.log文件:

cat distributed_gpt.log

请参考文件传输概述。 | |

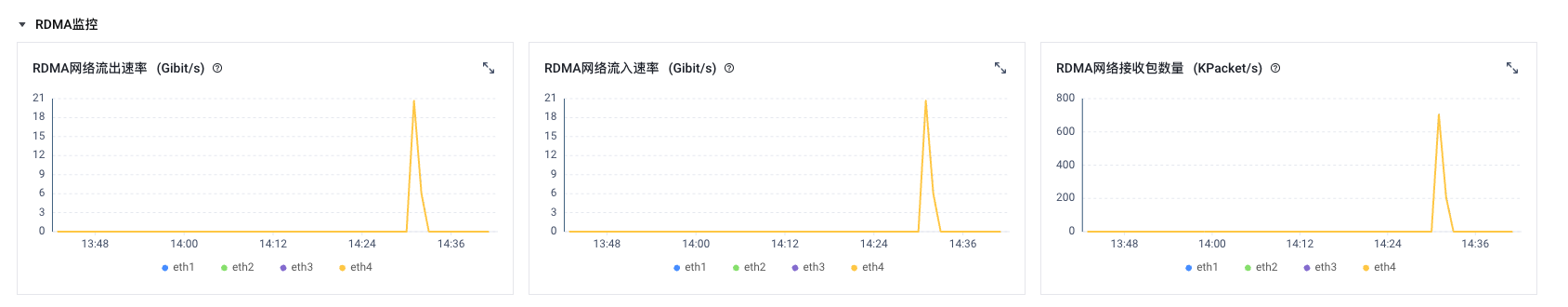

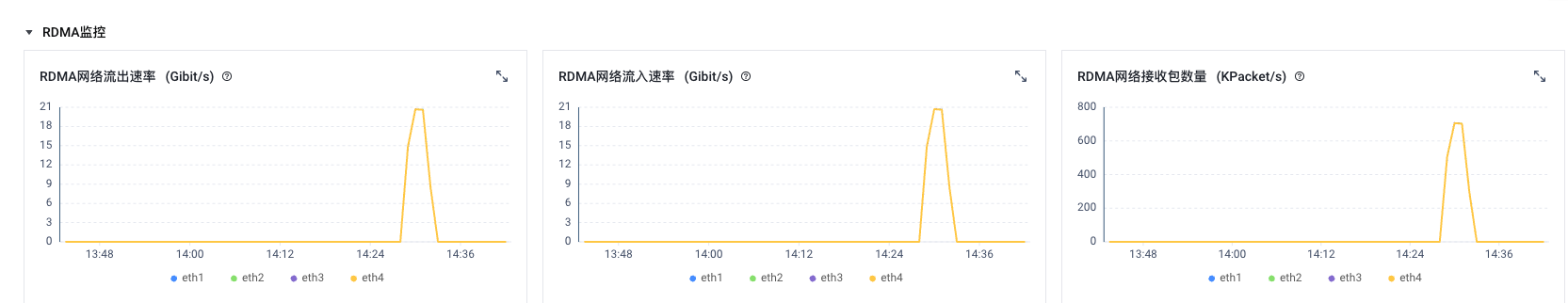

查看RDMA监控流量 | 如何查看实例GPU/RDMA监控数据。 | |

|

| |