👉点击这里申请火山引擎VIP帐号,立即体验火山引擎产品>>>

背景信息

精度 | 显存需求 | 推荐实例规格 | GPU显卡类型 |

FP16 | 27 GB | ecs.g1ve.2xlarge | V100 * 1(单卡32 GB显存) |

INT8 | 17 GB | ecs.gni2.3xlarge | A10 * 1(单卡24 GB显存) |

INT4 | 10 GB | ecs.gni2.3xlarge | A10 * 1(单卡24 GB显存) |

软件要求

NVIDIA驱动:

GPU驱动:用来驱动NVIDIA GPU卡的程序。本文以535.86.10为例。

CUDA:使GPU能够解决复杂计算问题的计算平台。本文以CUDA 12.2为例。

CUDNN:深度神经网络库,用于实现高性能GPU加速。本文以8.5.0.96为例。

运行环境:

Transformers:一种神经网络架构,用于语言建模、文本生成和机器翻译等任务。深度学习框架。本文以4.30.2为例。

Pytorch:开源的Python机器学习库,实现强大的GPU加速的同时还支持动态神经网络。本文以2.0.1为例。

Anaconda:获取包且对包能够进行管理的工具,包含了Conda、Python在内的超过180个科学包及其依赖项,用于创建Python虚拟环境。本文以Anaconda 3和Python 3.10为例。

Pytorch使用CUDA进行GPU加速时,在CUDA、GPU驱动已经安装的情况下,依然不能使用,很可能是版本不匹配的问题,请严格关注以上软件的版本匹配情况。

使用说明

操作步骤

步骤一:创建GPU计算型实例

请参考通过向导购买实例创建一台符合以下条件的实例:

基础配置:

计算规格:ecs.gni2.3xlarge

镜像:Ubuntu 20.04,不勾选“后台自动安装GPU驱动”。

存储:云盘容量在100 GiB以上。

网络配置:勾选“分配弹性公网IP”。

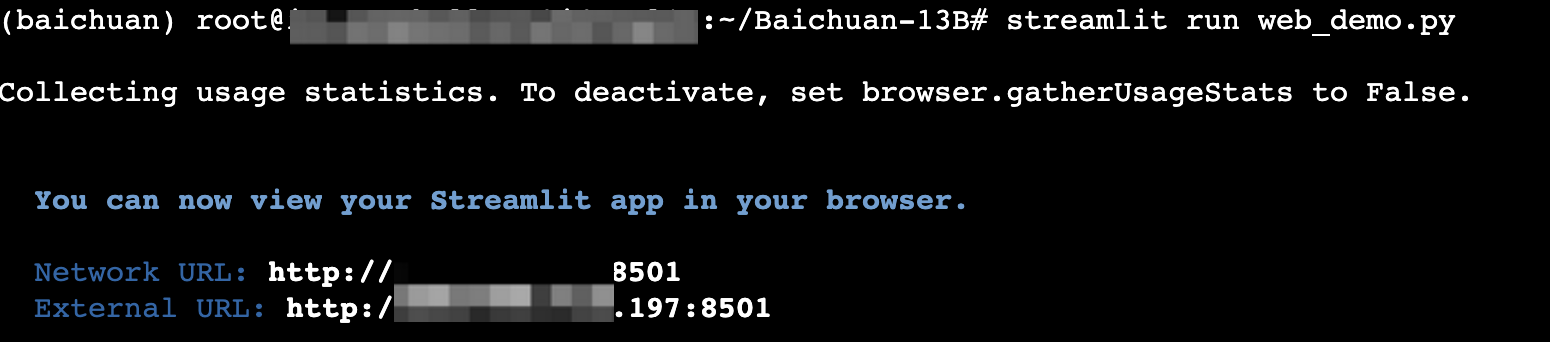

创建成功后,在实例绑定的安全组中添加入方向规则:放行TCP 8501端口。具体操作请参见修改安全组访问规则。

步骤二:安装GPU驱动和CUDA工具包

登录实例。

执行以下命令,下载CUDA Toolkit。

CUDA Toolkit大小约4G,其中已经包含了GPU驱动和CUDA,安装过程相对耗时,请耐心等待。

执行以下命令,安装GPU驱动和CUDA。

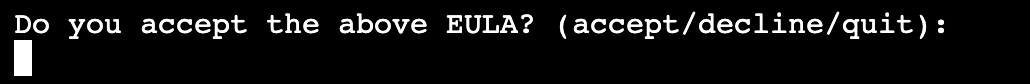

输入"accept",并按“Enter”键确认信息。

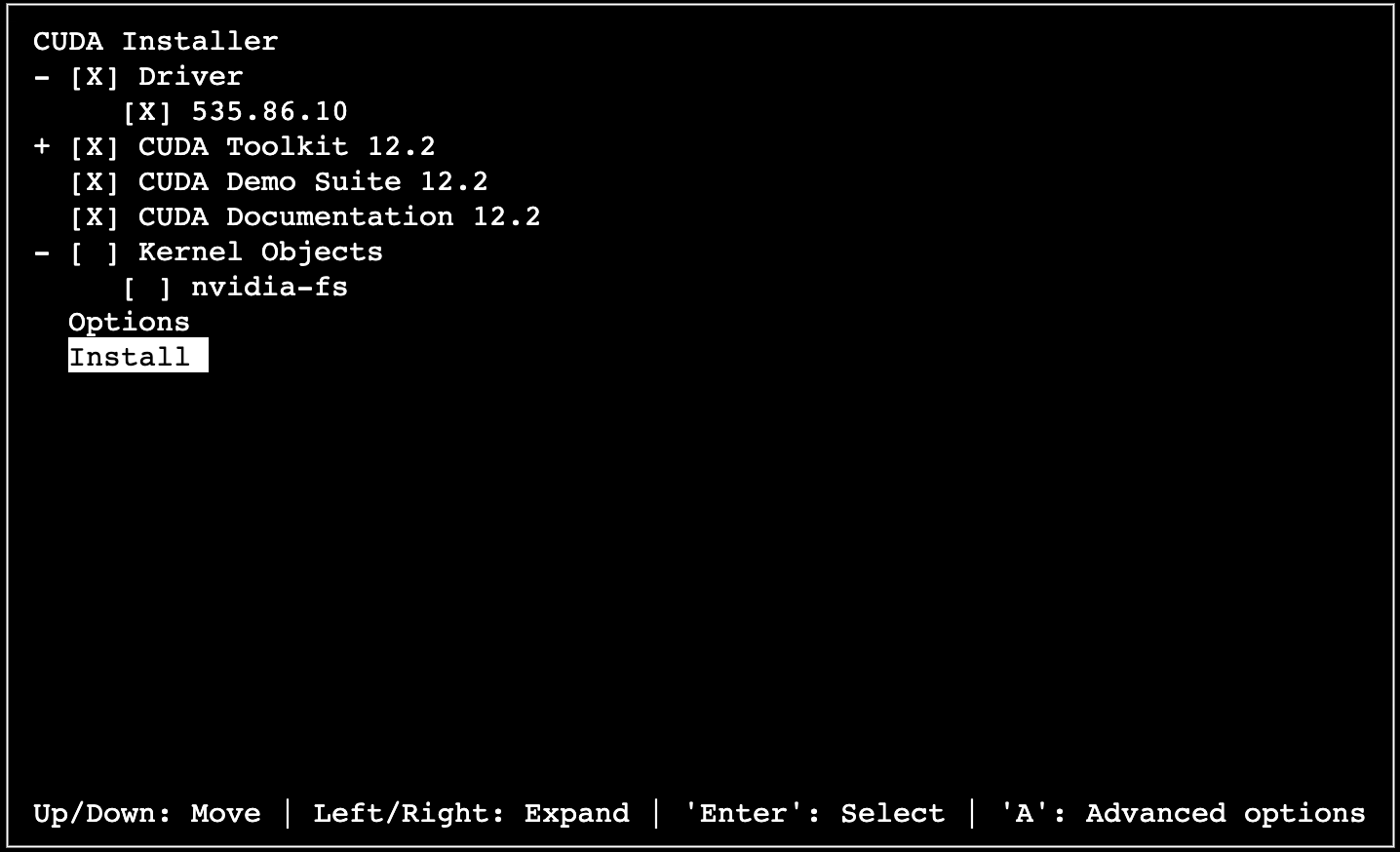

按键盘上下键选中【Install】,回车确认,开始安装。

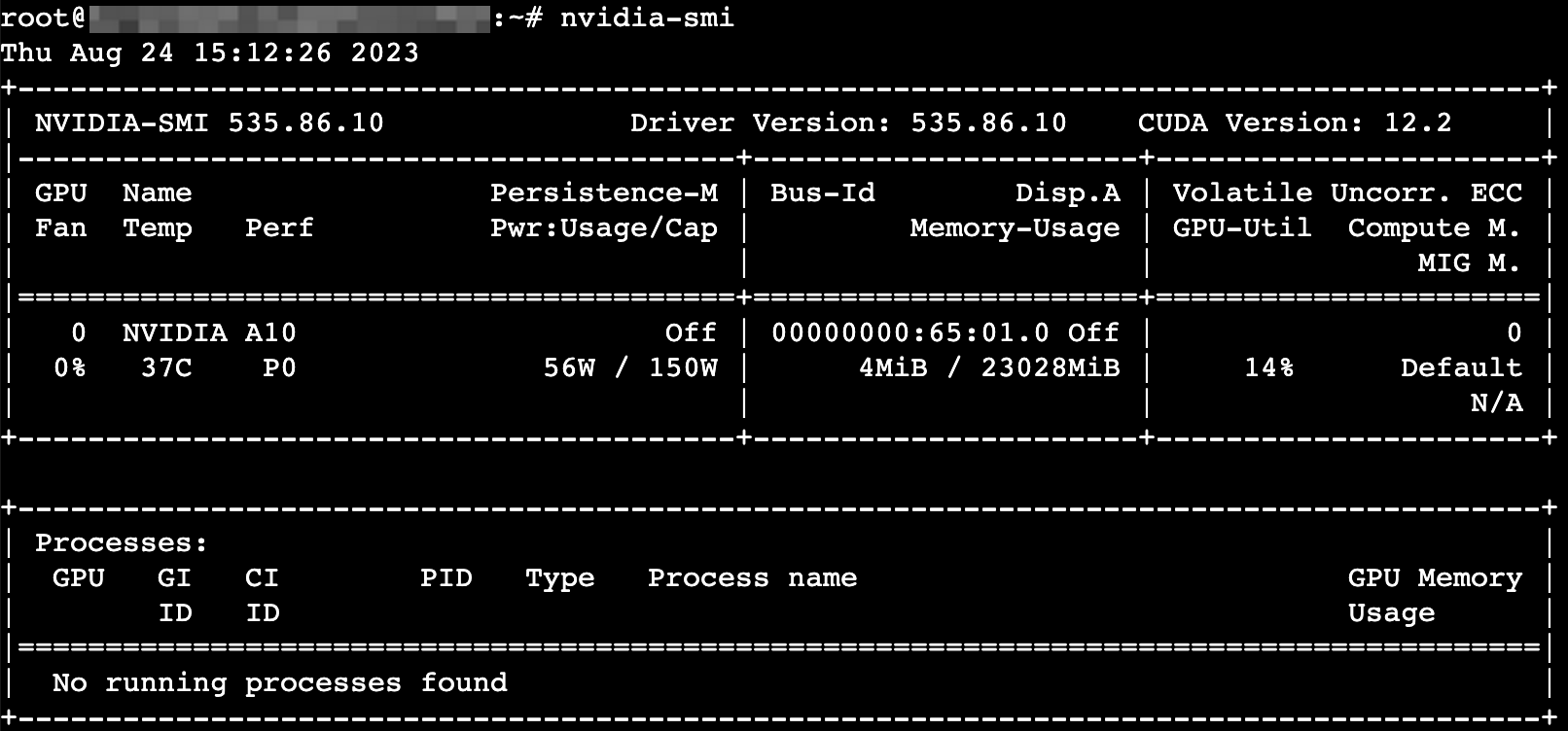

安装完成后,执行以下命令进行验证。

步骤三:创建虚拟环境

执行以下命令,下载Anaconda安装包。

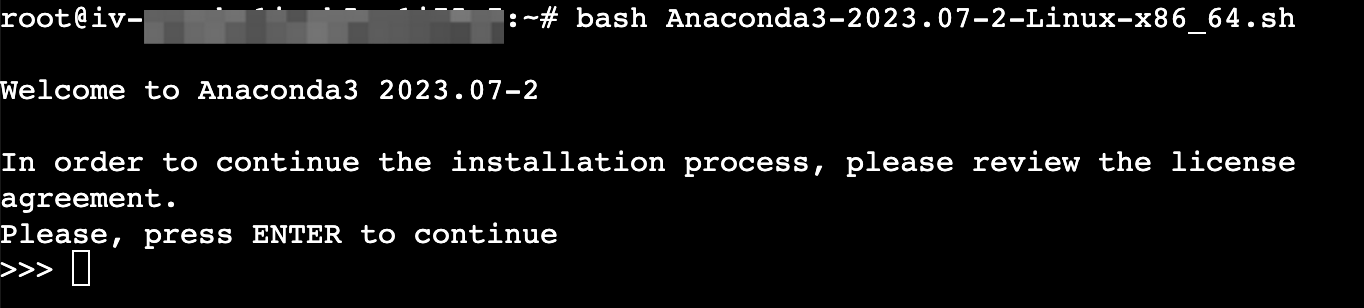

执行以下命令,安装Anaconda。

持续按“Enter”键进行安装。

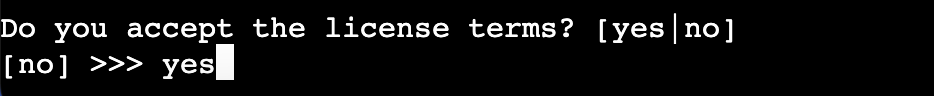

输入“yes”,并按“Enter”键确认信息。

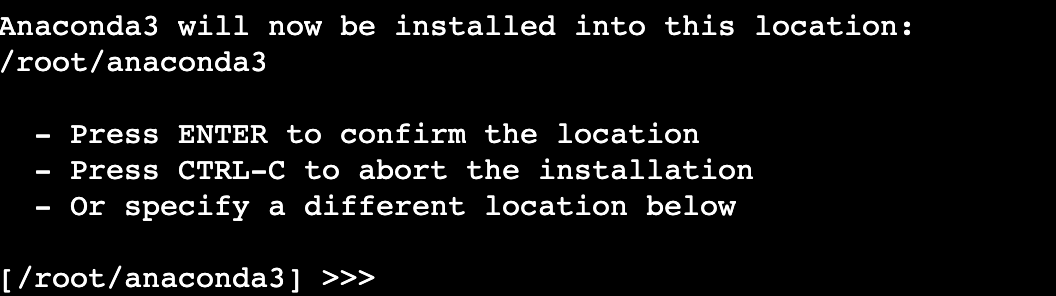

Anaconda的安装路径/root/anaconda3,请按“Enter”确认安装。

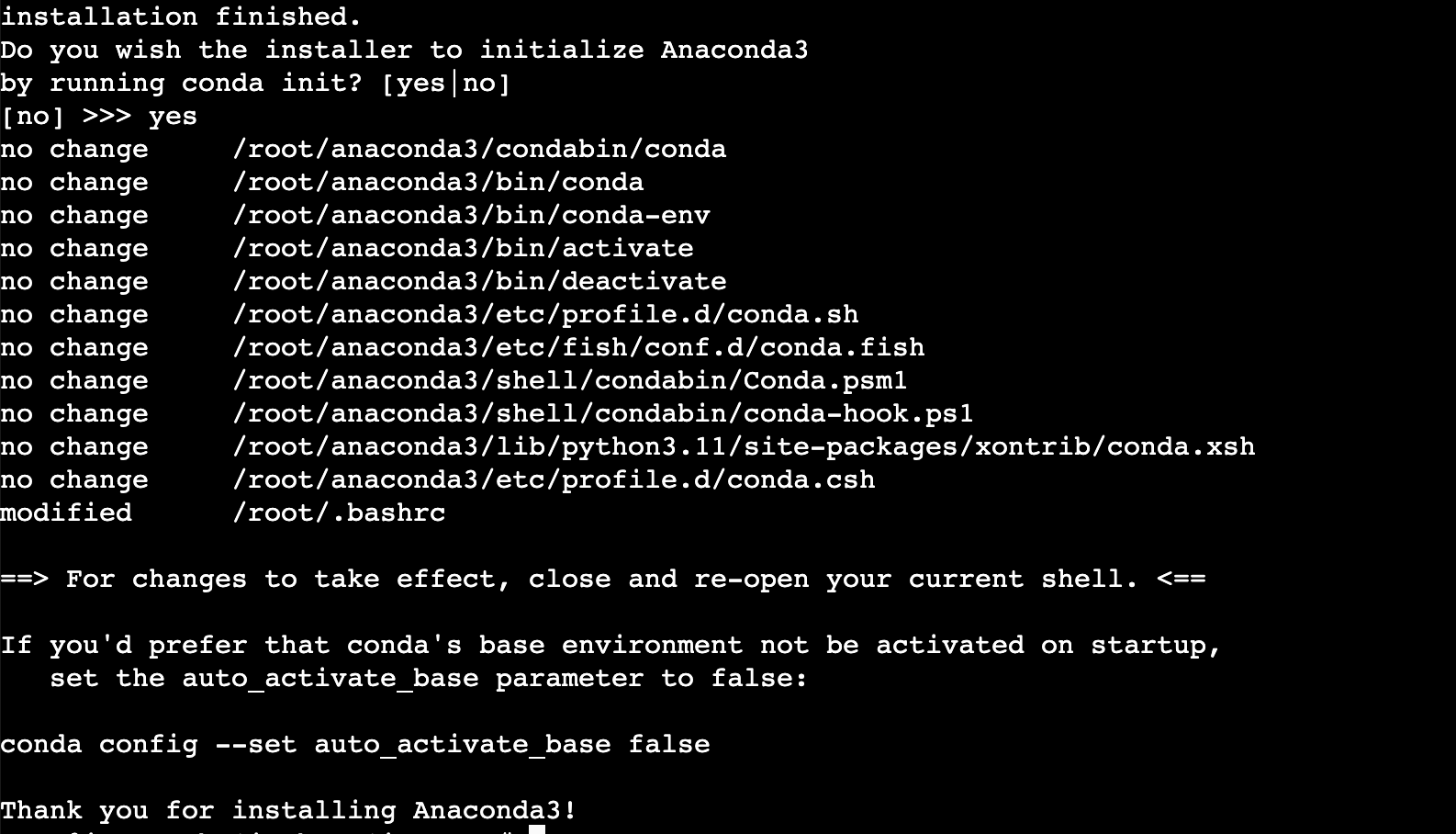

输入“yes”确定初始化Anaconda。

执行以下命令使配置文件生效。

创建一个名为“baichuan”的虚拟环境,并指定该环境中的python版本为3.10。

执行conda create -n baichuan python=3.10命令。

回显Proceed ([y]/n)?时输入“y”确认。

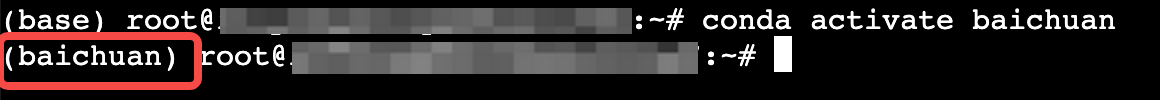

执行以下命令,激活虚拟环境。

步骤四:部署Baichuan-13B并验证

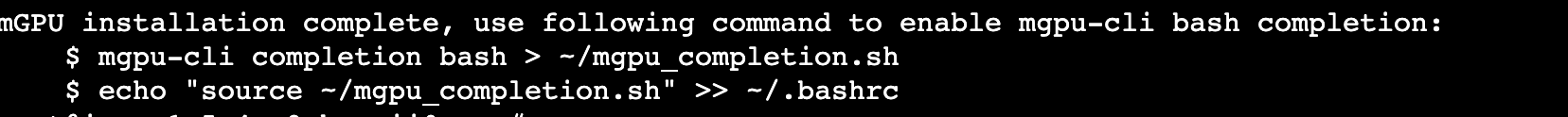

依次执行以下命令,配置 packagecloud 存储库并安装Git LFS。

curl -s https://packagecloud.io/install/repositories/github/git-lfs/script.deb.sh | sudo bashapt-get install git-lfs

执行以下命令初始化Git LFS。

执行以下命令,下载Baichuan-13B大模型的权重文件。

文件大小约26GB,整个过程会持续较长时间,请耐心等待。官方的权重文件保存在huggingface仓库。

执行以下命令,克隆官方示例代码。

依次执行以下命令,安装相应的依赖包。

cd Baichuan-13B # 工作目录切换到示例代码的路径pip install -r requirements.txt # 安装baichuan依赖

执行以下命令,启动示例代码中的“web_demo.py”。

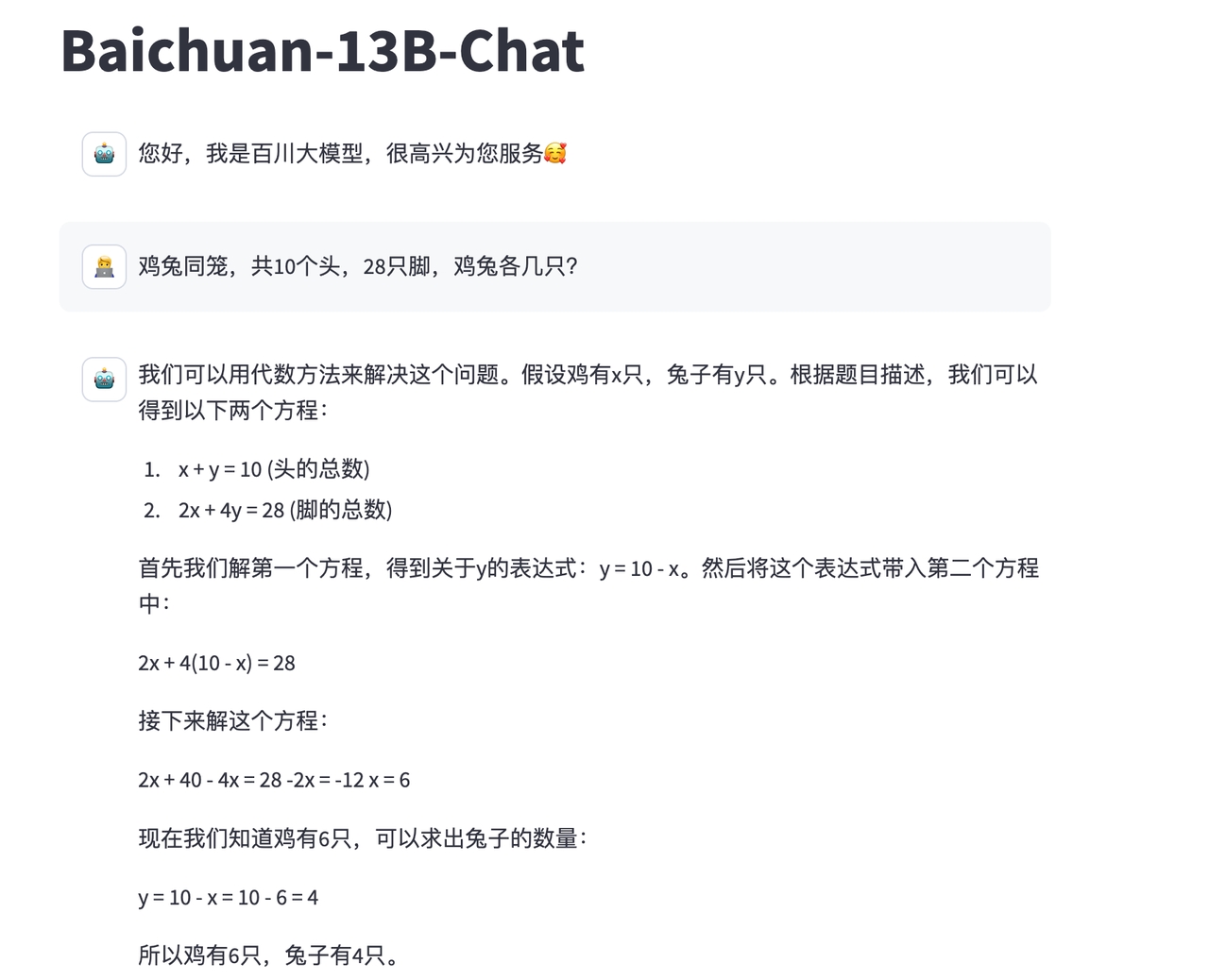

浏览器访问URL链接(http://<公网IP>:8501/)打开demo页面。